Материалы по тегу: периферийные вычисления

|

17.06.2023 [15:11], Владимир Мироненко

Lenovo представила новые ИИ-серверы для периферии и ЦОДLenovo планирует инвестировать $1 млрд в течение трёх лет в разработку оборудования и программного обеспечения для ИИ-сектора. Речь идёт не только о решениях для ЦОД, но и для периферии. Сейчас Lenovo занимается сертификацией большей части своего существующего оборудования для обработки ИИ-нагрузок. По словам Роберта Дейгла (Robert Daigle), старшего менеджера подразделения Lenovo ISG Global AI, компания работала с 45 партнёрами над созданием 150 систем и ИИ-решений «под ключ». На днях компания анонсировала два новых ИИ-сервера для периферийных вычислений. ThinkEdge SE360 V2 предназначен ускорених таких нагрузок, как компьютерное зрение, голосовой ИИ и генеративный ИИ. ThinkEdge SE360 V2 построен на базе процессоров Intel Xeon D-2700 и ускорителей NVIDIA A2/L4 (с поддержкой NVIDIA AI Enterprise) или Qualcomm Cloud AI 100. Устройство имеет компактные размеры (2U, ½ ширины) и прочный корпус, что позволяет его использовать в условиях неблагоприятной окружающей среды.

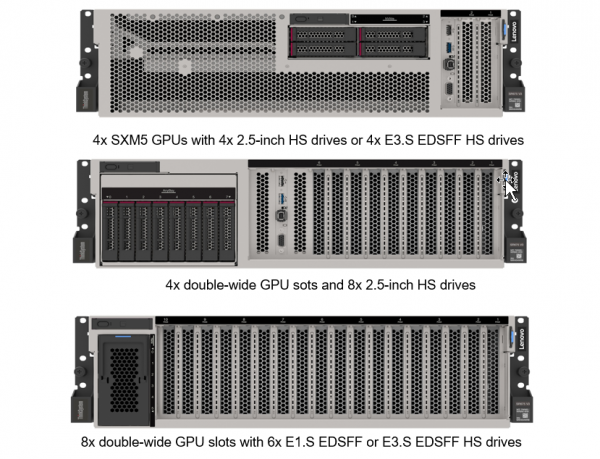

ThinkEdge SE360 V2 (Источник изображений: Lenovo) 1U-сервер Lenovo ThinkEdge SE350 V2 разработан для гибридного облака и использования в гиперконвергентной инфраструктуре. У этого сервера увеличенная ёмкость дисковой подсистемы в сочетании с процессором Intel Xeon D-2700 и 100G-подключением. Сервер главным образом предназначен для консолидации рабочих нагрузок, резервного копирования данных при совместной работе и доставке контента. Также Lenovo представила ИИ-сервер ThinkSystem SR675 V3 на базе AMD EPYC Genoa. В шасси высотой 3U можно разместить HGX-плату с четырьмя SXM-ускорителями H100 или четыре или восемь ускорителей двойной ширины NVIDIA или AMD. В зависимости от конфигурации доступны различные варианты дисковой подсистемы, но упор сделан на NVMe SSD. Также для платформы есть опция установки фирменной СЖО Neptune. ThinkSystem SR675 V3 оптимизирован для работы с цифровыми двойникам в сочетании с ИИ с целью улучшения бизнес-процессов и результатов проектирования. Lenovo также работала с NVIDIA над повышением производительности рабочих нагрузок Omniverse Enterprise. Ещё один новый проект Lenovo — Центр передового опыта Lenovo AI Discover, который проводит семинары для клиентов, желающих начать работу с такими технологиями, как генеративный ИИ и компьютерное зрение.

09.06.2023 [15:03], Сергей Карасёв

AWS создала загадочный сервер Snowblade в интересах военныхОблачная платформа AWS объявила о доступности специализированного сервера Snowblade, разработанного для проекта Joint Warfighting Cloud Capability (JWCC) Министерства обороны США (DoD). Система обладает повышенной надёжностью и может эксплуатироваться в экстремальных условиях. Характеристики сервера не раскрываются. Но сообщается, что он позволяет использовать до 208 vCPU. Устройство выполнено в форм-факторе 5U с шириной в половину стандартной стойки. Новинка соответствует стандарту MIL-STD-810H, что означает устойчивость к перепадам температур, вибрации, ударам, а также воздействию влаги и пыли. Утверждается, что Snowblade имеет самую высокую плотность компоновки среди всех систем AWS Snow. Решение рассчитано на выполнение ресурсоёмких задач в условиях ограниченного пространства.

Источник изображения: AWS Сервер Snowblade может использоваться на периферии. Он позволяет работать с рядом облачных сервисов AWS, включая Amazon EC2, AWS IAM, AWS CloudTrail, AWS IoT Greengrass, AWS Deep Learning AMIs, Amazon Sagemaker Neo и AWS DataSync. Отмечается, что система доступна только в регионе AWS GovCloud (US-West), а заказать новинку можно исключительно в рамках программы JWCC.

30.05.2023 [13:22], Сергей Карасёв

Доля мини-ЦОД в России к 2035 году может достичь 30 %В России ожидается значительный рост востребованности мини-ЦОД — относительно небольших дата-центров, которые могут располагаться вместе с базовыми станциями вблизи жилых домов или промышленных предприятий. Об этом сообщает газета «Ведомости, ссылаясь на проект «Стратегии развития отрасли связи в РФ на 2024–2035 годы». Говорится, что в России пока нет чётко сформировавшегося рынка мини-ЦОД. По оценкам, на долю таких площадок приходится приблизительно 2–3 % от общего объёма вычислений. Но к 2035-му показатель может вырасти на порядок, достигнув 30 %. По итогам 2022 года затраты в сегменте мини-ЦОД оказались на уровне 1 млрд руб. В ближайшие годы прогнозируется бурное развитие рынка, чему будут способствовать платформы Интернета вещей (IoT) и растущие объёмы передаваемого трафика.

Источник изображения: Ростелеком-ЦОД Участники рынка говорят, что в России сформировалась двухуровневая архитектура хранения и обработки данных. Первый уровень — это крупные ЦОД на несколько тысяч стоек, которые обычно строятся на окраинах больших городов. Ко второму уровню относятся небольшие дата-центры, необходимые для оперативной обработки ограниченного объёма информации и быстрого отклика современных сервисов. Такие мини-ЦОД могут развёртываться в том числе в районах массового скопления людей и на площадках операторов связи. Среди ключевых игроков отрасли названы российские производители Datark, Utilex, «Айсо», «НПО инжиниринг» («Телекор»), C3 Solutions, а также интеграторы «Инлайн», «Ланит» и Sitronics. Ожидается, что мини-ЦОД будут располагаться вдоль федеральных трасс, в городах небольшого размера, в крупных транспортных узлах и местах массовых мероприятий. Драйверами отрасли названы региональная цифровизация, развитие сетей 5G и создание новых доступных решений. Однако развёртывание небольших дата-центров может быть затруднено из-за более высоких затрат на строительство по сравнению с ЦОД большого масштаба.

21.09.2022 [01:10], Алексей Степин

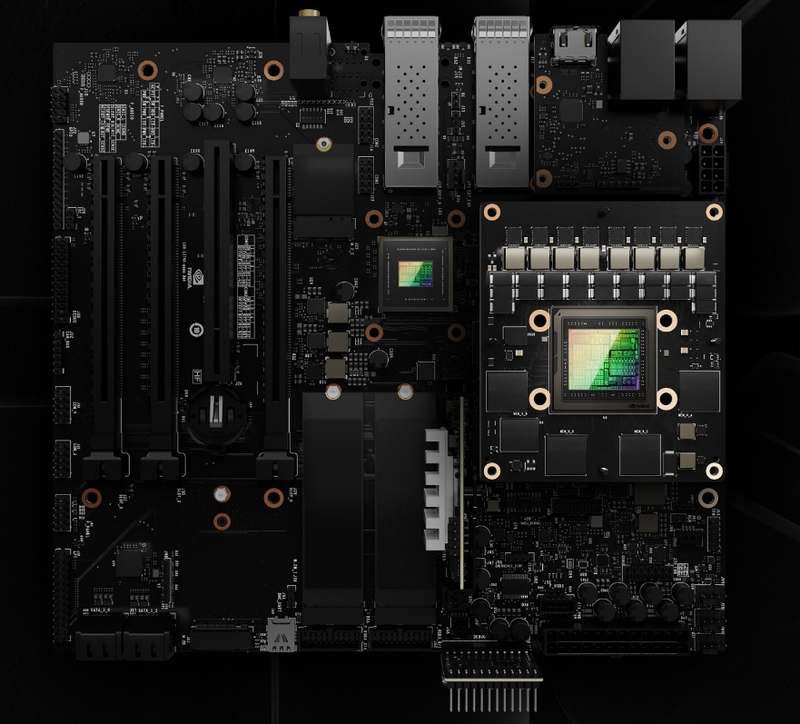

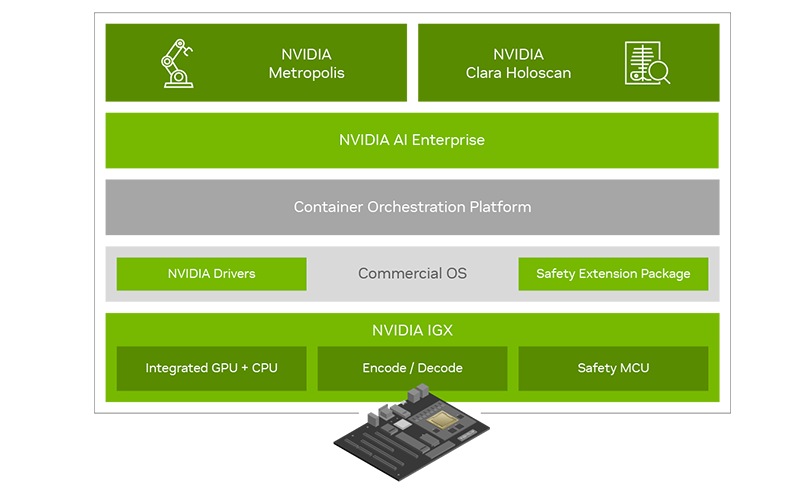

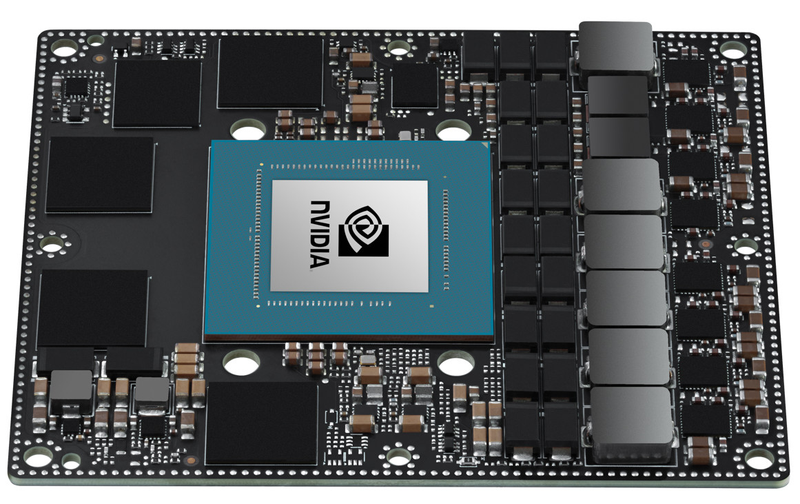

NVIDIA представила платформу IGX для «умной» промышленности и медициныПомимо новых GPU с архитектурой Ada компания NVIDIA на конференции GTC 2022 анонсировала множество новинок и не последней из них стала новая периферийная платформа IGX, призванная вывести «умную» промышленность на новый уровень. Главный упор в IGX сделан на обеспечении повышенной безопасности, причём как информационной, так и физической. Использовать совместный труд роботов в промышленности пытаются уже давно, но до недавних пор такие решения были нестандартными и весьма дорогостоящими. IGX призвана обеспечить безопасность, стандартизацию и высокий уровень производительности, достаточный для современной робототехники. Сердцем платформы IGX являются высокоинтегрированные модули серии Jetson AGX Orin, сочетающие в себе достаточно мощный процессор общего назначения, GPU-ускоритель, ускорители ИИ, машинного зрения, а также отдельный сопроцессор sMCU, отвечающий за обеспечение безопасности в проактивном режиме. Последний работает в комплексе с новыми программными расширениями, легко интегрируемыми в большинство коммерческих ОС благодаря сопутствующему программному стеку NVIDIA AI Enterprise.

NVIDIA IGX. Здесь и далее источник изображений: NVIDIA Что касается проактивной защиты, то, к примеру, получив сигнал с видеокамер о том, что человек приближается к «зоне ответственности» роботов, система автоматически изменит траекторию движения последних, предупредит сотрудников, а также на основании полученных данных скорректирует поведение роботов в дальнейшем. Также с помощью технологии «цифровых двойников» можно будет провести симуляцию, дабы заранее выяснить возможные точки потенциально опасных столкновений машин и людей.

NVIDIA IGX сделает подобные сценарии безопасными Производительность центрального модуля IGX составляет 275 Топс в режиме INT8. Обеспечение сетевых возможностей возложено на плечи современного сетевого адаптера ConnectX-7, гарантирующего прецизионные тайминги, позволяющие использовать платформу не только в промышленности, но и в медицине, где вопросы безопасности и точности жизненно важны. Естественно, индустрия нового поколения не может обойтись без унифицированных средств управления и обеспечения кибербезопасности. Весь комплекс решений на базе новой платформы IGX может развёртываться и управляться с единой консоли с помощью облачной системы NVIDIA Fleet Command. За безопасность при этом отвечает выделенный контроллер. На более высоком уровне за интеграцию новой платформы в единую экосистему отвечает фреймворк NVIDIA Metropolis, с помощью которого можно создавать по-настоящему крупномасштабные комплексы, включая целые «умные города».

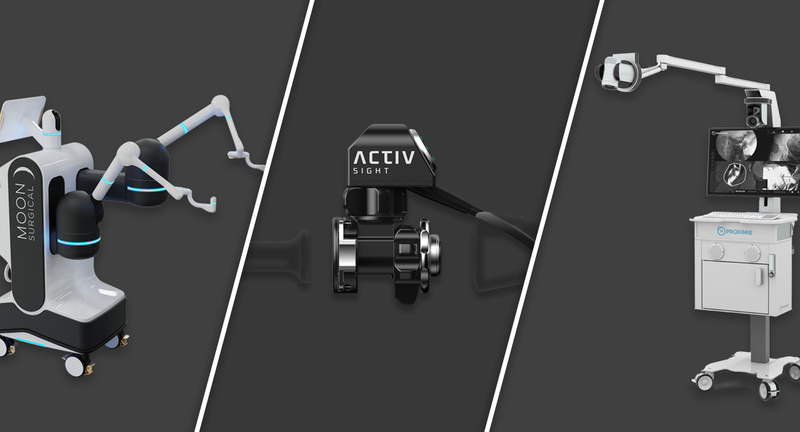

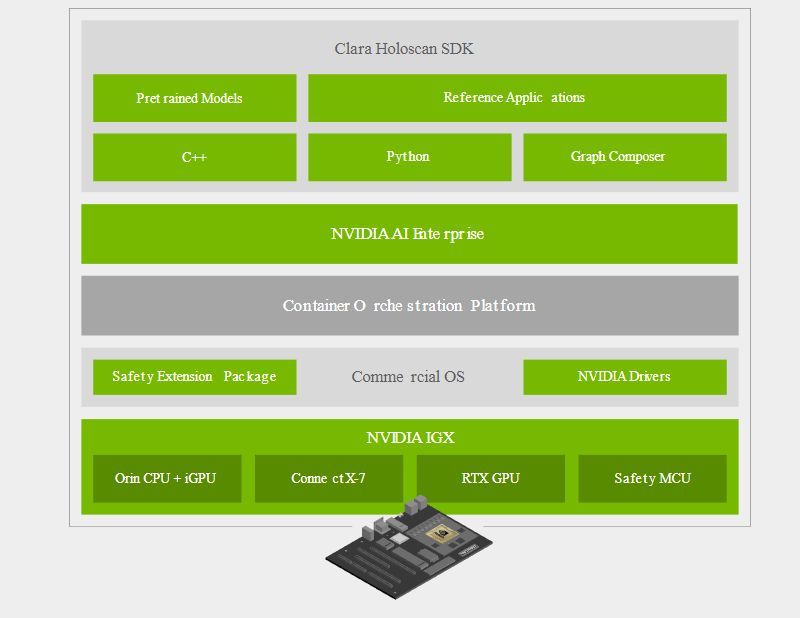

Программно-аппаратный состав новой платформы Отдельного упоминания заслуживает то, что новая платформа NVIDIA IGX избрана в качестве основы разработчиками медицинских систем, в частности, цифровой и робо-хирургии, такими как Activ Surgical, Moon Surgical и Proximie. Это стало возможным как благодаря аппаратным свойствам платформы, таким как низкая латентность и гарантированное время отклика, так и сочетанию фреймворков MONAI и Clara Holoscan.  Первый позволяет обучать специфические ИИ-модели на основании массивов медицинских данных. Эти модели затем могут интегрироваться с помощью Clara Holoscan SDK в реальные системы ультразвукового сканирования, эндоскопии или робохирургии. Помимо встроенных средств ускорения IGX, Clara Holoscan поддерживает и внешние ускорители NVIDIA RTX A6000, а технология Rivermax обеспечит передачу видеоданных для робота-хирурга на скорости 100 Гбит/с прямо в набортную память GPU.  Комплекты разработчика IGX Orin будут доступны заказчикам в начале следующего года. Уже достигнуты соглашения с производителями встраиваемого оборудования ADLINK, Advantech, Dedicated Computing, Kontron, Leadtek, MBX, Onyx, Portwell, Prodrive Technologies и YUAN; уже испытывает новинку в деле Siemens. Также NVIDIA сотрудничает с Canonical, Red Hat и SUSE в целях обеспечения долговременной поддержки платформы, срок которой составит не менее 10 лет.

16.04.2022 [23:54], Алексей Степин

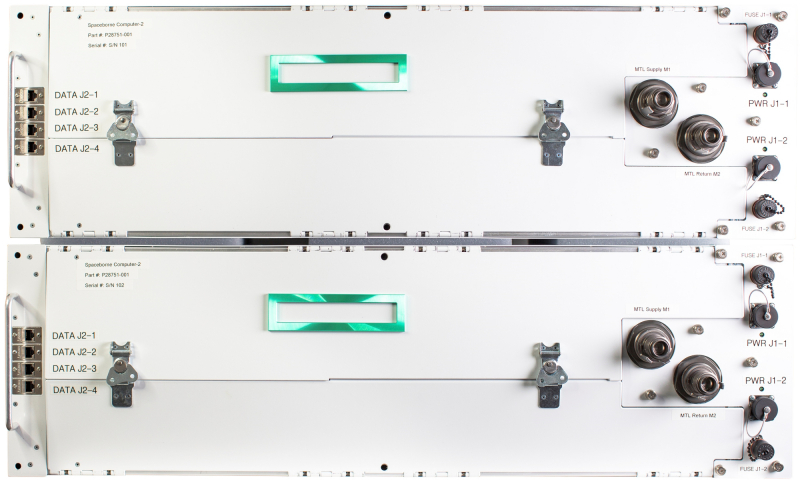

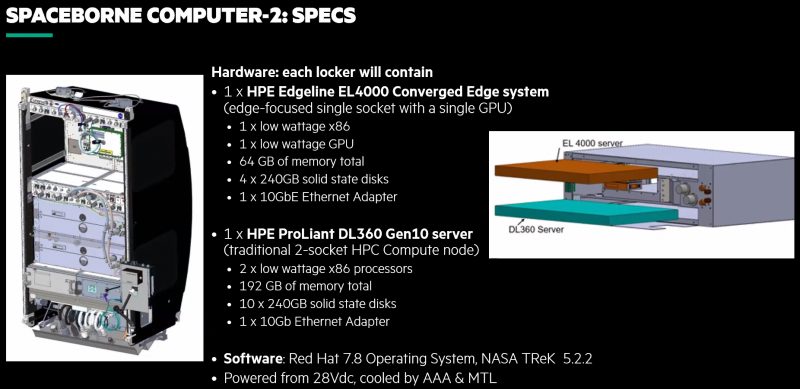

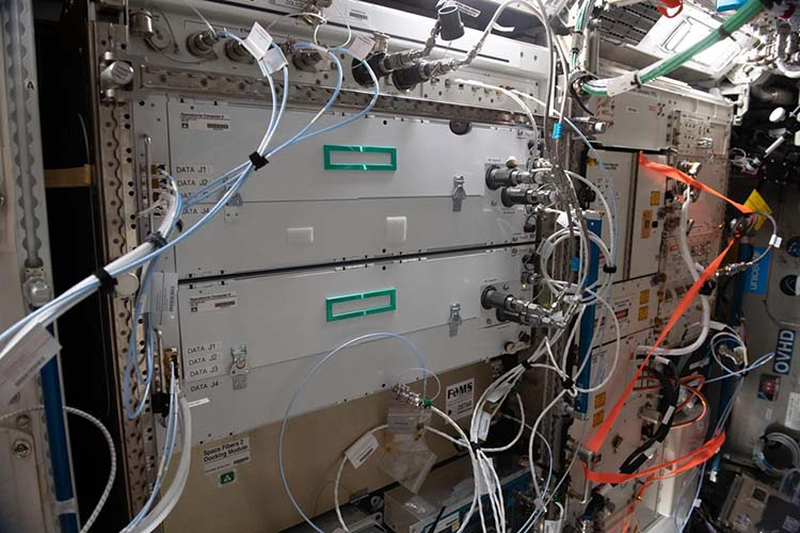

Космический суперкомпьютер HPE Spaceborne-2 успешно завершил 24 эксперимента на МКСПериферийные вычисления подразумевают работу достаточно мощных серверов в нестандартных условиях. Казалось бы, 400 километров — не такое уж большое расстояние. Но если это высота орбиты космической станции, то более «периферийное» место найти будет сложно. А ведь если человечество планирует и далее осваивать космос, оно неизбежно столкнётся и с проблемами, свойственными космическим ЦОД. Первый космический суперкомпьютер, как его окрестили создатели из HPE, появился в 2017 году и успешно проработал на орбите 615 дней. Инженеры учли выявленные особенности работы такой системы на орбите и в прошлом году отправили на МКС Spaceborne-2 (SBC-2), который стал вдвое производительнее предшественника. Хотя SBC-2 по земным меркам и невелик и состоит всего из двух вычислительных узлов (HPE Edgeline EL4000 и HPE ProLiant DL360 Gen10, совокупно чуть более 2 Тфлопс), это самая мощная компьютерная система, когда-либо работавшая в космосе. К тому же, это единственная космическая вычислительная система, оснащённая ИИ-ускорителем NVIDIA T4.

HPE Spaceborne-2 (Изображения: HPE) Теперь же HPE сообщает, что эта машина меньше чем за год помогла в проведении 24 важных научных экспериментов. Всё благодаря достаточно высокой производительности. Одним из первых стал стал анализ генов — обработка данных непосредственно на орбите позволила снизить объём передаваемой информации с 1,8 Гбайт до 92 Кбайт. Но это далеко не единственный результат. Так, ИИ-ускорители были задействованы для визуального анализа микроскопических повреждений скафандров, используемых для выхода в открытый космос. Они же помогли в обработке данных наблюдения за крупными погодными изменениями и природными катаклизмами. Также был проведён анализ поведения металлических частиц при 3D-печати в невесомости, проверена возможность работы 5G-сетей космических условиях, ускорены расчёты требуемых объёмов топлива для кораблей и т.д. Ряд проблем ещё предстоит решить: в частности, в условиях повышенной космической радиации существенно быстрее выходят из строя SSD, что естественно для технологии, основанной на «ловушках заряда». По всей видимости, для дальнего космоса целесообразнее будет использовать накопители на базе иной энергонезависимой памяти. Впрочем, при освоении Луны или Марса полагаться на земные ЦОД тоже будет трудно, а значит, достаточно мощные вычислительные ресурсы придётся везти с собой.

26.03.2022 [00:48], Владимир Агапов

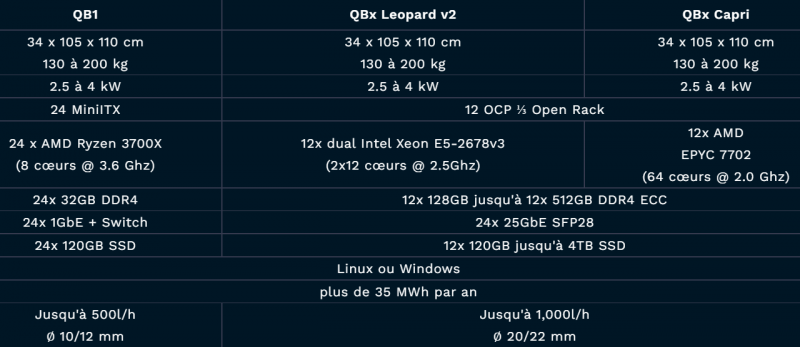

Микро-ЦОД вместо котельной — Qarnot предложила отапливать дома б/у серверами«Зелёная» экономика, переход на которую стремится осуществить всё больше стран, требует радикального сокращения вредного воздействия техносферы на окружающую среду. Один из эффективных способов достижения этой задачи связан с включением в полезный оборот побочных продуктов экономической деятельности. В случае дата-центров таким продуктом является тепло. Великобритания, Дания и другие страны направляют тепло от ЦОД в отопительные системы домов, а Норвегия обогревает им омаровые фермы и планирует обязать дата-центры отдавать «мусорное» тепло на общественные нужды. Французская компания Qarnot решила посмотреть на эту задачу под другим углом, разработав в 2017 г. концепцию электрообогревателя для жилых и офисных помещений на процессорах AMD и Intel. В 2018 г. Qarnot продолжила изыскания и выпустила криптообогреватель QC-1. А недавно она порадовала своих заказчиков следующим поколением отопительных устройств QB, которое создано в сотрудничестве с ITRenew. Новые модули используют OCP-серверы, которые ранее работали в дата-центрах гиперскейлеров. Оснащённые водяным охлаждением, они обогревают помещения пользователей и обеспечивают дополнительные мощности для периферийных облачных вычислений. Система отводит 96% тепла, производимого кластером серверов, которое попадает в систему циркуляции воды. IT-часть состоит из процессоров AMD EPYC/Ryzen или Intel Xeon E5 в составе OCP-платформ Leopard, Tioga Pass или Capri с показателем PUE, который, по словам разработчиков, стремится к 1,0. При этом вся система практически бесшумная, поскольку вентиляторы отсутствуют. В компании заявляют, что с февраля уже развёрнуто 12 000 ядер, и планируется довести их число до 100 000 в течении 2022 года. Среди предыдущих заказчиков систем отопления Qarnot числятся жилищные проекты во Франции и Финляндии, а также банк BNP и клиенты, занимающиеся цифровой обработкой изображений. По словам технического директора Qarnot Клемента Пеллегрини (Clement Pellegrini), QB приносит двойную пользу экологии, используя не только «мусорное» тепло, но и оборудование, которое обычно утилизируется. У ITRenew уже есть очень похожий совместный проект с Blockheating по обогреву теплиц такими же б/у серверами гиперскейлеров.

24.02.2022 [19:00], Алексей Степин

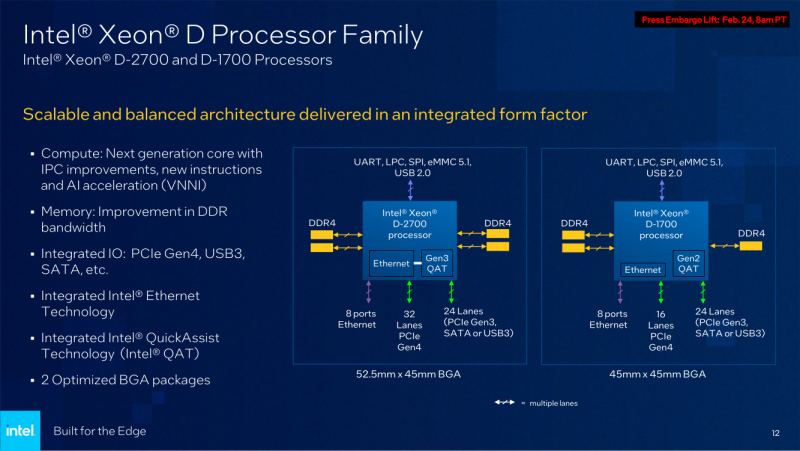

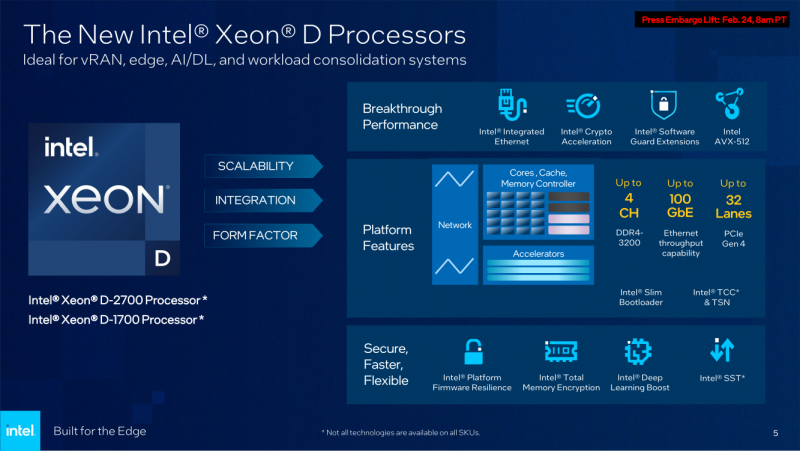

Intel анонсировала процессоры Xeon D-1700 и D-2700: Ice Lake-SP + 100GbEКонцепция периферийных вычислений сравнительно молода и до недавнего времени зачастую её реализации были вынуждены обходиться стандартными процессорами, разработанными для применения в серверах, или даже в обычных ПК и ноутбуках. Intel, достаточно давно имеющая в своём арсенале серию процессоров Xeon D, обновила модельный ряд этих CPU, которые теперь специально предназначены для использования на периферии. Анонс выглядит очень своевременно, поскольку по оценкам Intel, к 2025 году более 50% всех данных будет обрабатываться вне традиционных ЦОД. Новые серии процессоров Xeon D-1700 и D-2700 обладают рядом свойств, востребованных именно на периферии — особенно на периферии нового поколения. Новинки имеют следующие особенности:

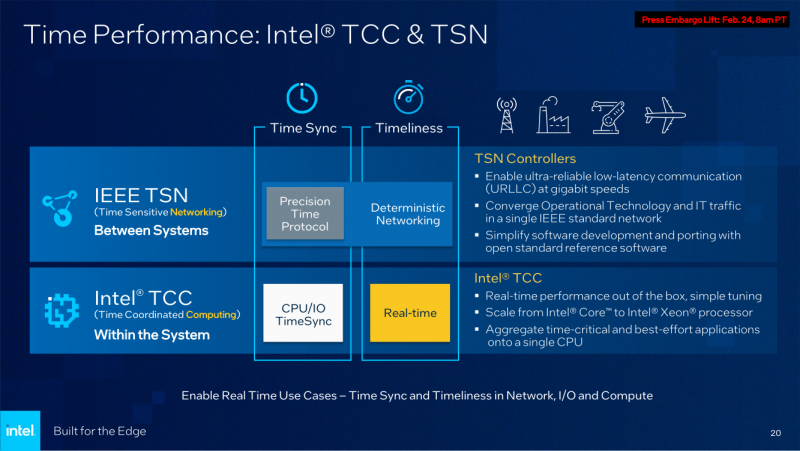

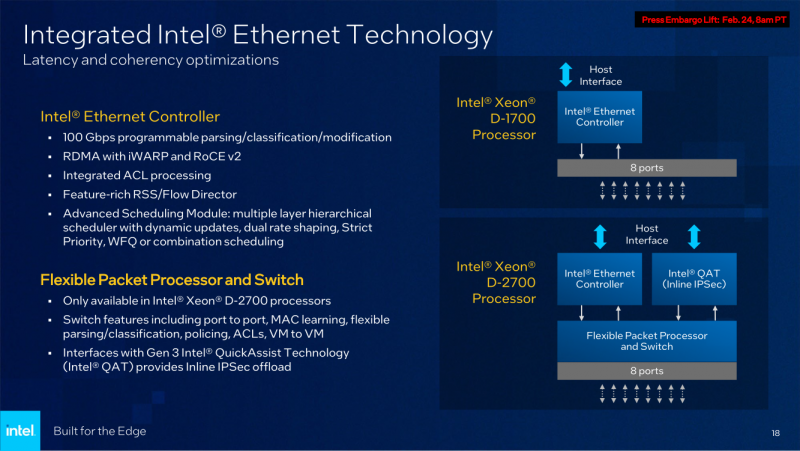

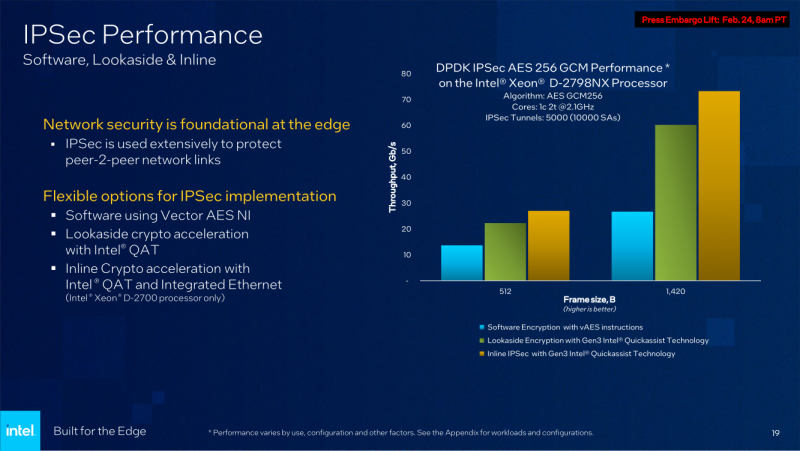

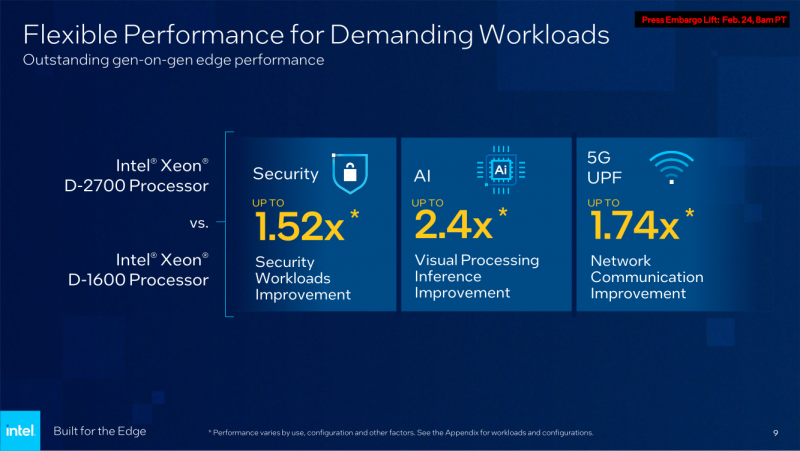

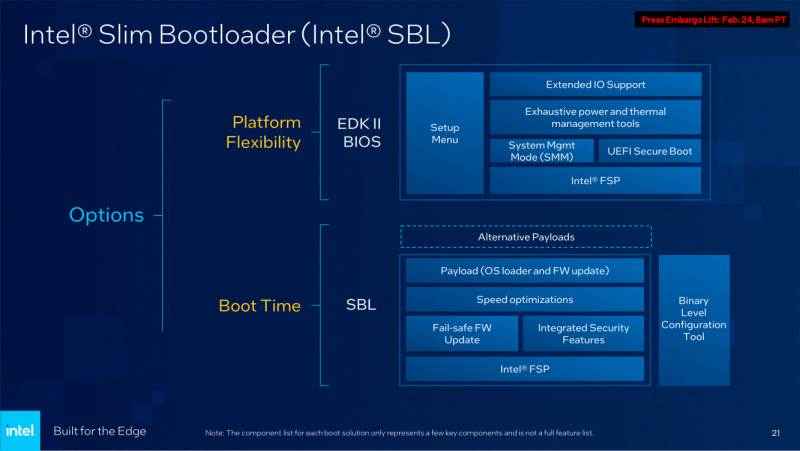

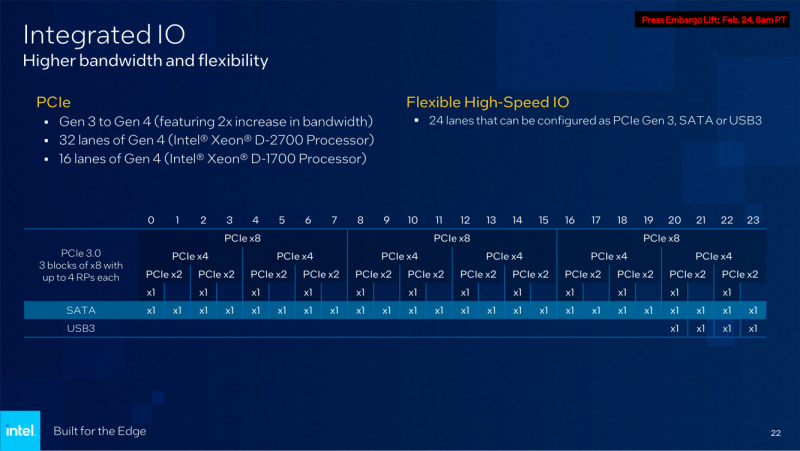

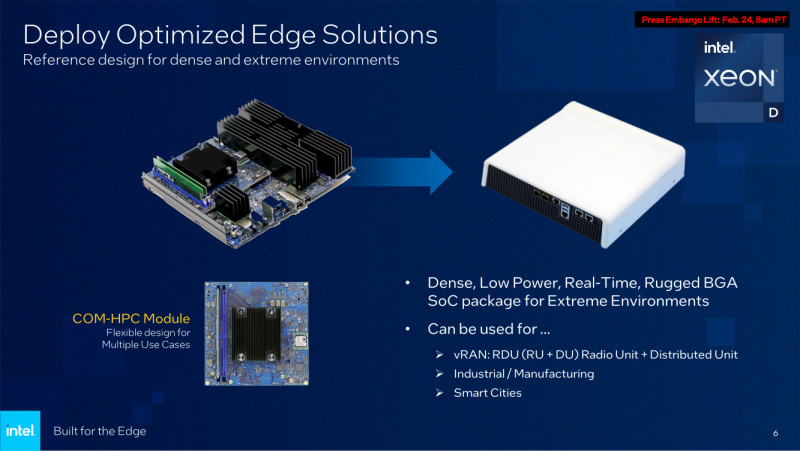

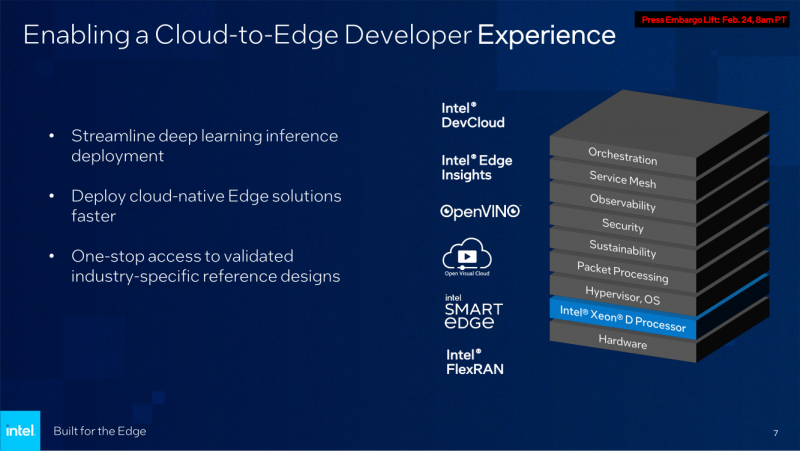

Последний пункт ранее был реализован в процессорах серий Atom x6000E, Xeon W-1100E и некоторых процессорах Core 11-го поколения. Вкратце это технология, позволяющая координировать вычисления с точностью менее 200 мкс в режиме TCC за счёт точной синхронизации таймингов внутри платформы. И здесь у Xeon D, как у высокоинтегрированной SoC, есть преимущество в реализации подобного класса точности. Помогает этому и наличие специального планировщика для общего кеша L3, позволяющего добиться более консистентного доступа к кешу и памяти. Это незаменимая возможность для систем, обслуживающих сверхточные промышленные процессы, тем более что Intel предлагает хорошо документированный набор API и средств разработки для извлечения из режима TCC всех возможностей. Важной также выглядит наличие поддержки пакета технологий Intel QuickAssist (QAT) для ускорения задач (де-)шифрования и (де-)компрессии. Третье поколение QAT, доступное, правда, только в Xeon D-2700, в отличие от второго (и это случай D-1700), связано в новых SoC непосредственно с контроллером Ethernet и встроенным программируемым коммутатором. В частности, поддерживается, и IPSec-шифрование на лету (inline) на полной скорости, и классификация (QoS) трафика. Также реализована поддержка новых алгоритмов, таких, как Chacha20-Poly1305 и SM3/4, имеется собственный движок для публичных ключей, улучшены алгоритмы компрессии. Но QAT может работать и совместно с CPU (lookaside-разгрузка), а можно и вовсе обойтись без него, воспользовавшись AES-NI. Поддержке безопасности помогает и полноценная поддержка защищённых вычислительных анклавов SGX, существенно ограничивающая векторы атак как со стороны ОС и программного обеспечения, так и со стороны гипервизора виртуальных машин. Это важно, поскольку на периферии уровень угрозы обычно выше, чем в контролируемом окружении в ЦОД, но для использования SGX требуется модификация ПО. В целом, «ядерная» часть новых Xeon-D — это всё та же архитектура Ice Lake-SP. Так что Intel в очередной раз напомнила про поддержку DL Boost/VNNI для работы с форматами пониженной точности и возможности эффективного выполнения инференс-нагрузок — новинки почти в 2,5 раза превосходят Xeon D-1600. Есть и прочие стандартные для платформы функции вроде PFR или SST. Из важных дополнений можно отметить поддержку Intel Slim BootLoader. Масштабируемость у новой платформы простирается от 2 до 10 (D-1700) или 20 (D-2700) ядер, а TDP составляет 25–90 и 65–129 Вт соответственно. В зависимости от модели поддерживается работа в расширенном диапазоне температур (до -40 °C). У обоих вариантов упаковка BGA, но с чуть отличными размерами — 45 × 45 мм против 45 × 52,5 мм. На этом различия не заканчиваются. У младших Xeon D-1700 поддержка памяти ограничена тремя каналами DDR4-2933, а вот у D-2700 четыре полноценных канала DDR4-3200. Однако возможности работы с Optane PMem обе модели лишены, несмотря на то, что контроллер памяти их поддерживать должен. Представитель Intel отметил, что если будет спрос со стороны заказчиков, то возможен выпуск вариантов CPU с поддержкой PMem. Дело в том, что прошлые поколения Xeon-D использовались и для создания СХД, а наличие 100GbE-контроллера с RDMA делает новинки не менее интересными для этого сегмента. Кроме того, есть и поддержка NTB, да и VROC с VMD вряд ли исчезли. Для подключения периферии у D-2700 доступно 32 линии PCIe 4.0, а у D-1700 — 16. У обоих серий CPU также есть 24 линии HSIO, которые на усмотрение производителя можно использовать для PCIe 3.0, SATA или USB 3.0. Впрочем, пока Intel предлагает использовать всё это разнообразие интерфейсов для подключения ускорителей и различных адаптеров. Поскольку в качестве одной из основных задач для новых процессоров компания видит их работу в качестве контроллеров программно-определяемых сетей, включая 5G, она разработала для этой цели референсную платформу. В ней предусматривается отдельный модуль COM-HPC с процессором и DIMM-модулями, что позволяет легко модернизировать систему. А базовая плата предусматривает наличие радиотрансиверов, что актуально для сценария vRAN. Поскольку речь идёт не столько о процессорах, сколько о полноценной платформе, Intel серьезное внимание уделила программной поддержке, причём, в основе лежат решения с открытым программным кодом. Это позволит заказчикам систем на базе новых Xeon D разворачивать новые точки и комплексы периферийных вычислений быстрее и проще. Многие производители серверного аппаратного обеспечения уже готовы представить свои решения на базе Xeon D-1700 и 2700.

24.01.2022 [15:37], Сергей Карасёв

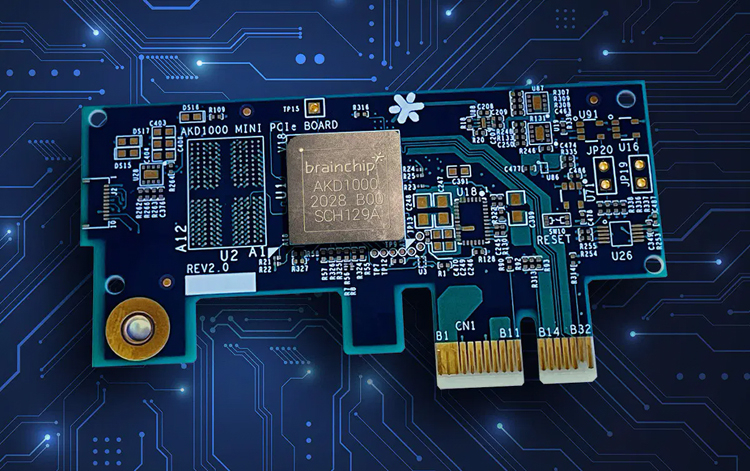

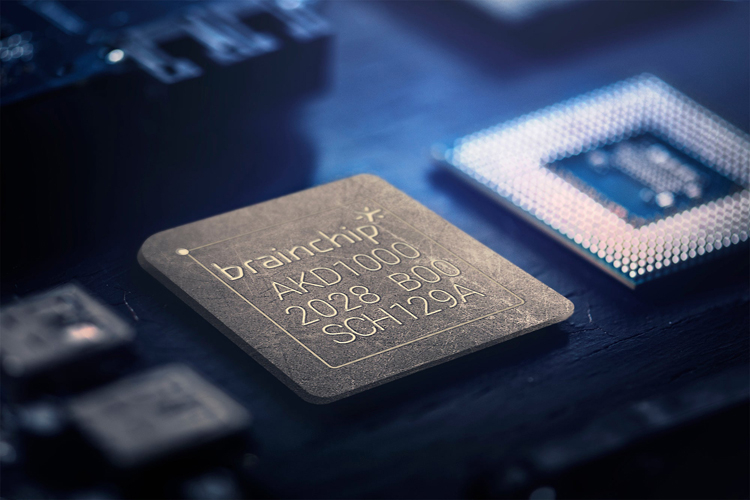

Нейроморфный ИИ-ускоритель BrainChip Akida AKD1000 оценён в $499Компания BrainChip сообщила о начале продаж специализированной карты расширения Akida AKD1000, предназначенной для организации периферийных ИИ-вычислений. Цена изделия составляет $499: оно доступно для заказа в количестве до десяти штук. Сама плата имеет размеры 76 × 40 × 5,3 мм и использует интерфейс PCI Express 2.0 x1. В основу положен одноимённый нейроморфный процессор, дополненный ядром Arm Cortex-M4 (300 МГц). Akida AKD1000 предлагает 1,2 млн нейронов и 10 млрд синапсов. Решение содержит 512 Мбайт памяти LPDDR4-2400 и 128 Мбит флеш-памяти Quad SPI NOR.

Источник изображений: BrainChip Отмечается, что BrainChip предоставит заказчикам всю необходимую документацию, что позволит системным интеграторам и разработчикам создавать собственные решения на базе ИИ-акселератора. Создание, обучение и тестирование нейросетей осуществляется в среде MetaTF с поддержкой Tensorflow и Keras, а также набором готовых моделей и конвертером CNN-SNN.  На поставку новых карт Akida AKD1000 будет уходить около восьми недель после оформления заказа. Эти сроки будут варьироваться в зависимости от работы логистических цепочек. Впрочем, это временные ограничения, так как, по словам компании, налажено массовое производство. Ранее BrainChip выпустила комплекты разработчика на базе ПК Shuttle и Raspberry Pi

19.12.2021 [18:06], Алексей Степин

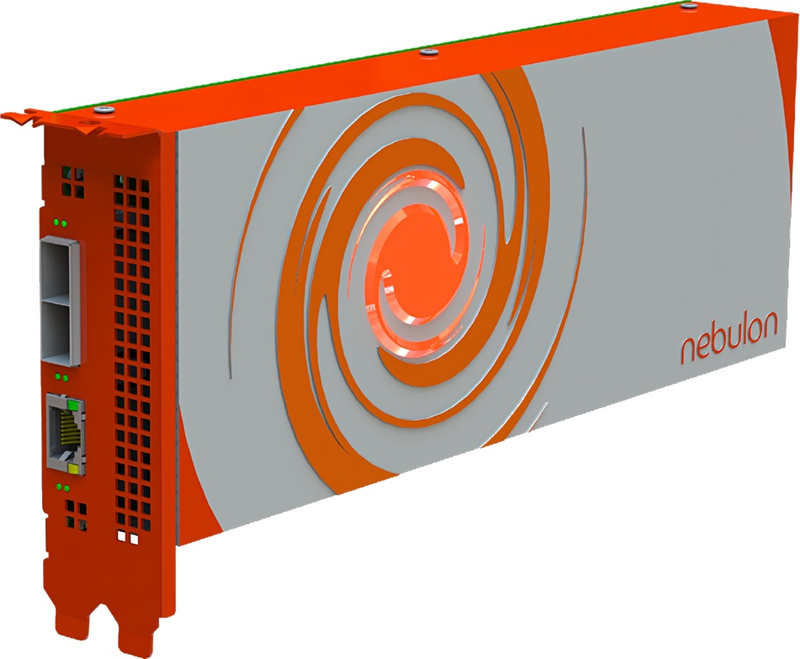

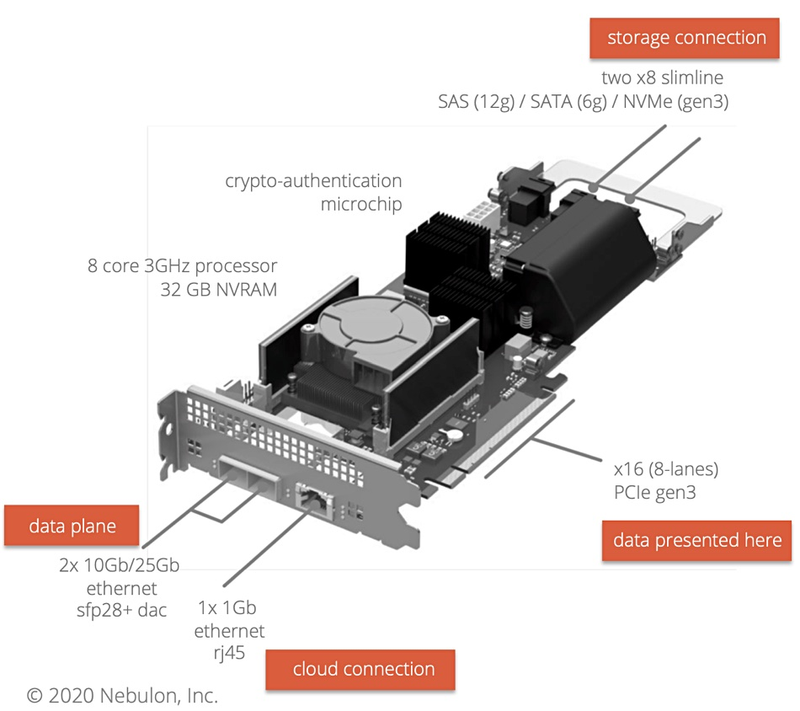

Nebulon поможет HCI-решениям освоить рынок периферийных вычисленийПо мере внедрения 5G-сетей объёмы данных, добываемых и обрабатываемых на периферии, будут только расти, и здесь новое решение Nebulon для микро-ЦОД окажется весьма к месту. Компания Nebulon была основана лишь 2018 году, а в 2020 году она представила свои первые решения, концептуально очень схожие с тем, что сейчас принято называть DPU. Изначально это были ускорители под названием SPU (Storage Processing Unit), однако впоследствии первое слово заменили на Service, поскольку речь шла уже об облачных системах, и данные платы стали частью того, что сама Nebulon называет «умной инфраструктурой» (Smart Infrastructure).

Nebulon SPU. Изображения: Nebulon Но у SPU нашлось и ещё одно применение, связанное с периферийной серверной инфраструктурой. Её особенности таковы, что требуют максимальной компактности оборудования, и это, по мнению Nebulon, затрудняет использование классических решений для гиперконвергентной инфраструктуры (HCI), поскольку, по словам Nebulon, она обычно для арбитража, который необходим для стабильности работы, требует наличия в системе минимум трёх узлов.  Такой «узел-арбитр» (quorum witness, QW) гарантирует бесперебойную работу системы в том случае, если какой-либо из её основных узлов испытывает проблемы с сетевым подключением. Но в условиях периферии третьему узлу бывает просто негде разместиться, а ведь нужен ещё и сетевой коммутатор. Тут-то на помощь и может прийти ускоритель Nebulon SPU, который можно назвать полноценным «сервером на плате»: он несёт на борту восьмиядерный CPU и 32 Гбайт DRAM. Основным интерфейсом SPU является PCIe 3.0 x16 (8 линий) + ещё два набора по 8 линий могут обслуживать NVMe SSD (но есть и поддержка SAS/SATA). С такой платой HCI-кластер может иметь в составе всего два узла. Коммутатор не требуется, поскольку плата располагает двумя портами 10/25GbE. Интеграцию такого HCI-кластера с облаком, автоматизацию и арбитраж посредством Nebulon ON также берёт на себя SPU. Компания-разработчик назвала данную технологию smartEdge.

09.11.2021 [12:33], Алексей Степин

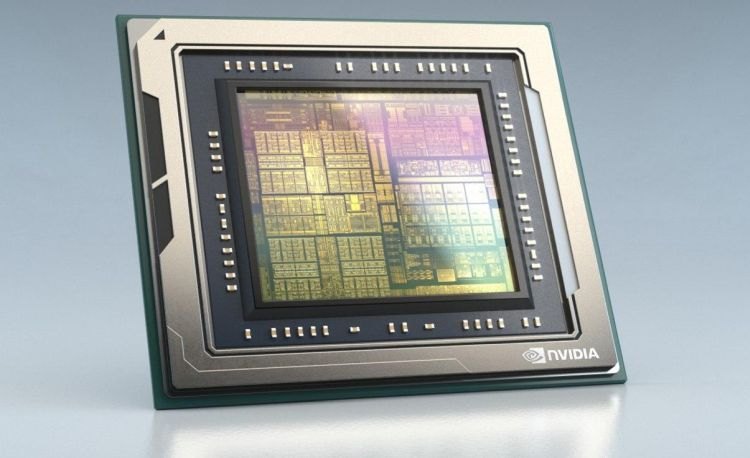

NVIDIA представила платформу Jetson AGX Orin для периферийных ИИ-вычислений, робототехники и автономного транспортаОдним из лидеров в создании высокопроизводительных встраиваемых решений давно является NVIDIA с серией Jetson. На смену уже немолодой платформе Jetson AGX Xavier пришла Jetson AGX Orin, обладающая ускорителем с архитектурой Ampere. Компания не без оснований называет Jetson AGX Orin самой мощной, компактной и энергоэффективной платформой для робототехники, автономного транспорта и встраиваемых решений для работы на периферии — её производительность оценивается в 200 Топс, что более чем в шесть раз выше показателей Xavier. По словам NVIDIA новинка сравнима по скорости работы с GPU-сервером, но при этом умещается на человеческой ладони.  Новая 7-нм SoC состоит из 17 млрд транзисторов. Она включает 12 ядер Cortex-A78AE, одних из самых мощных в арсенале Arm, предназначенных для задач класса mission critical и имеющих продвинутые механизмы защиты от системных сбоев Это немаловажно, к примеру, при применении в беспилотных транспортных средствах и промышленной автоматике. Всё это дополнено 2048 ядрами NVIDIA Ampere. ускорители. Ускорена подсистема памяти (200 Гбайт/с). Серьёзно возросли сетевые возможности — новый чип имеет сразу четыре интерфейса 10 Гбит/с.  Разработчики решений на базе Jetson AGX Orin могут использовать NVIDIA CUDA-X, JetPack SDK и наиболее новые версии утилит NVIDIA. Также на момент анонса уже доступны предварительно натренированные и оптимизированные под новую платформу ИИ-модели из каталога NVIDIA TAO, которые помогут сократить время создания новых решений на базе Orin. Доступность новых плат Jetson AGX запланирована на первый квартал следующего года. Дабы не пропустить этот момент, NVIDIA предлагает зарегистрироваться в соответствующем разделе своего сайта. |

|